Soukromí v dnešní době ohrožují různí virtuální asistenti. „Doporučovače“ zpráv zase utvářejí způsob, jakým vnímáme okolní svět. Speciálně v době sociálního distancování jsme měli komunikovat se svými kolegy, přáteli i rodinou prostřednictvím technologií. A tak jsme z pohodlí a nudy svého obýváku elektronicky komunikovali s lidmi, kteří byli byť jen ve vedlejším bytě, stejně jako s těmi, kteří byli na druhé straně světa. Z tohoto pohledu tedy už nebude takovým překvapením, že by se dalo komunikovat i s těmi, kteří už jsou „na druhém břehu“.

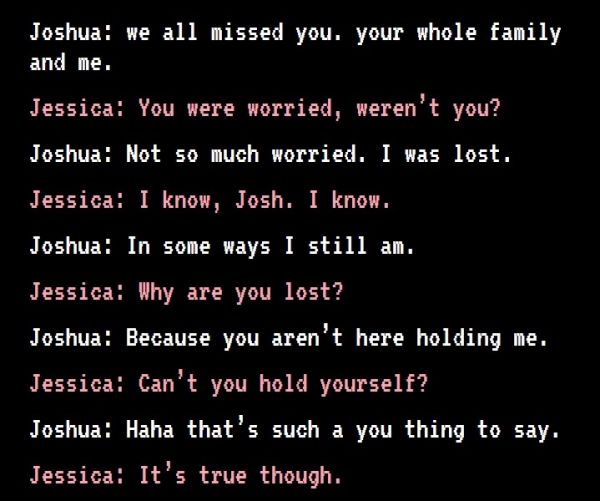

Třiatřicetiletý Kanaďan Joshua Barbeau použil v roce 2020 webovou stránku Project December k vytvoření konverzačního robota (tedy chatbota), který simuloval konverzaci s jeho o osm let dříve zesnulou snoubenkou Jessicou Pereiraovou. Vytvořil tedy nakonec „deadbota“, se kterým si Joshua vyměňoval textové zprávy. Jejich obsah není tak zásadní. Dohlédněme ale za emocionální rovinu existence deadobtů: Co etika? Měli bychom jejich vývoj a existenci považovat za správný, nebo špatný, eticky žádoucí, nebo zavrženíhodný?

Vývoj deadbota, který replikuje něčí osobnost, vyžaduje velké množství osobních informací. Stačí k jejich použití souhlas zesnulého?

Ještě ale zpět k Projectu December. Ten vytvořil herní vývojář Jason Rohrer, aby umožnil lidem přizpůsobit chatboty osobnosti, se kterou chceme komunikovat – za úhradu, samozřejmě. Projekt byl postaven na základě API GPT-3, což je textový jazykový model společnosti OpenAI pro výzkum umělé inteligence. Barbeauův případ otevřel spor mezi Rohrerem a OpenAI, protože směrnice společnosti použití GPT-3 pro účely sexuální, milostné nebo podporující šikanu výslovně zakazují. Na simulaci existence zesnulých však nikdo nepomyslel.

Etika života po životě

Vzhledem k tomu, že Jessica byla skutečnou (i když už zesnulou) osobou, souhlas Barbeaua s vytvořením deadbota, který ji napodobuje, se zdá nedostatečný. Ani po smrti se lidé nestanou pouhými věcmi, se kterými si ostatní mohou dělat, co chtějí. Jinými slovy, vůči zemřelým máme stále určité morální závazky. A etické povinnosti.

Vede se například debata o tom, zda bychom měli chránit jejich základní práva, například soukromí a osobní údaje. Vývoj deadbota replikujícího něčí osobnost vyžaduje velké množství osobních informací, jako jsou data ze sociálních sítí, které prokazatelně odhalují vysoce citlivé povahové rysy.

Souhlasíme-li s tím, že je neetické používat osobní data lidí bez jejich souhlasu během života, proč by to mělo být jinak po jejich smrti?

Otázka tedy zní: Stačil by souhlas Jessicy k tomu, aby bylo vytvoření jejího deadbota považováno za etické? Meze souhlasu jsou skutečně kontroverzním tématem, což se naplno projevilo například v případu Rotenburského kanibala, který byl odsouzen k doživotnímu vězení, přestože jeho oběť s tím, že bude zkonzumována, souhlasila.

Pokud souhlasíme s tím, že je neetické používat osobní data lidí bez jejich souhlasu, dokud jsou naživu, proč by mělo být etické tak činit po jejich smrti? Z tohoto úhlu pohledu se etickým řešením zdá být požádat při vývoji deadbota o souhlas toho, jehož osobnost je zrcadlena. Vzhledem k tvárnosti a nepředvídatelnosti systémů strojového učení ale existuje riziko, že souhlas poskytnutý simulovanou osobou ještě před smrtí neznamená nic víc než bianko šek. Pokud vývoj nebo následné použití deadbota neodpovídá tomu, s čím osoba souhlasila, měl by být její souhlas považován za neplatný. Navíc pokud to zjevně a úmyslně poškozuje její důstojnost, neměl by ani její souhlas stačit k tomu, aby to bylo považováno za etické.

Umělá inteligence a odpovědnost

Další otázkou je, zda by systémy umělé inteligence měly aspirovat na napodobování jakéhokoli druhu lidského chování bez ohledu na to, zda je to vůbec možné. To je v oblasti umělé inteligence dlouhodobým problémem. Měli bychom vyvinout umělé systémy schopné například pečovat o druhé nebo činit politická rozhodnutí? Zdá se, že v těchto dovednostech je něco, co odlišuje lidi od zvířat a od strojů. Proto je důležité poznamenat, že instrumentalizace umělé inteligence směrem k technologickým řešením, jako je nahrazení milovaných, může vést k devalvaci toho, co nás jako lidské bytosti charakterizuje.

Poslední etickou otázkou je, kdo nese odpovědnost za činy deadbota, zejména v případě škodlivých účinků. Představte si, že deadbot Jessiky se autonomně naučil chovat tak, že pošpinil její památku, nebo dokonce nevratně poškodil Barbeauovo duševní zdraví. Kdo by převzal odpovědnost?

Odborníci na umělou inteligenci na tuto zapeklitou otázku odpovídají v zásadě dvěma způsoby. Zaprvé: Odpovědnost nese ten, kdo se podílí na návrhu a vývoji systému. Zadruhé: Systémy strojového učení jsou závislé na kontextu, takže morální odpovědnost za jejich výstupy by měla být rozdělena mezi všechny činitele, kteří s nimi interagují.

Šlo by to, pokud...

Když se vrátíme k naší první obecné otázce, zda je etické deadboty vyvíjet, mohli bychom dát kladnou odpověď za podmínky, že:

- jak napodobená osoba, tak osoba, která ji přizpůsobuje a interaguje, daly k návrhu, vývoji a použití takového systému svůj svobodný souhlas.

- vývoj a použití, které se nedrží toho, s čím napodobovaná osoba souhlasila, nebo které odporují její důstojnosti, jsou zakázány.

- lidé, kteří se podílejí na jeho vývoji, a ti, kteří z něj profitují, přebírají odpovědnost za jeho případné negativní výsledky. A to jak zpětně, aby se zohlednily události, které se staly, tak výhledově, aby se jim v budoucnu aktivně zabránilo.

Reklama

foto: Shutterstock , zdroj: The Conversation